百度搜索引擎为了整顿互联网的信息内容,大尺度推出“百度原创星火计划”,为了此计划能高力度执行,建立了相应的专题页,更是邀请高质量的站点加入星火计划。我们现在面对的正是一个充斥着“重复内容”、“大量垃圾内容”的时代,星火计划中搜索引擎又是如何识别重复内容的?

搜索引擎为给用户提供高质量的内容,在用户搜索相关内容时,会通过一些过滤机制过滤掉重复的内容,而不是展示出大量重复相同的结果,如果网站存在大量重复内容,在搜索引擎过滤过程中可能会给网站带来影响。

搜索引擎来站点抓取内容之前,已经有爬行页面预计,如果网站存在大量的重复页面,蜘蛛会对这些页面进行一一检索,虽然在返回的结果被过滤,但是却浪费了蜘蛛对站点页面抓取的预算,减少了蜘蛛抓取其他高质量页面的机会,重复页面一样的也会分散网站的整体权重,这样并导致蜘蛛中能获取到的有意义的页面减少。

站长无法判断搜索蜘蛛会抓取重复页面中那个版本,搜索引擎自己也无法清除说明,用户不同的搜索,蜘蛛返回的页面可能是不同的,存在的重复页面可能也有不同的偏向,用户搜索时返回的页面是否是你最喜欢返回的页面,是否能给你带来最高的流量转化率?这些都是不得而知的,要想减少重复页面的权重分散,可以在robots文件中屏蔽收录,或者添加canonical标签转移权重。

像上面分析到的情况,重复内容会影响蜘蛛的抓取。同时,搜素引擎为了互联网生态公平健康发展及优质原创网站的集体利益,减少原创价值被采集站所得,会对重复、装载、垃圾信息站点进行惩罚。搜素引擎提出这样的申明,它又是怎么去识别重复内容的呢?

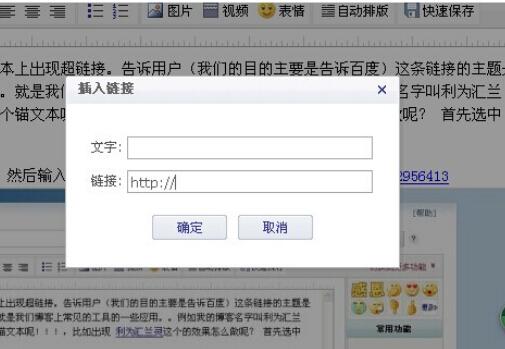

重复内容可以发生在不同的站点,也可以发生在同一个网站上,非优化的SEO优化CMS系统,导致网站存在多个URL地址可访问同一个页面,这样的情况也是重复内容,蜘蛛遇到这样的情况时会判断哪个页面才是重要的页面,会先从robots文件中检测,是否有禁止抓取的地址,如果有则停止对重复页面地址的抓取,如果没有就会继续抓取内容,在抓取时于遇到meta标签,注明noindex这些页面并不是为蜘蛛准备的,这种情况蜘蛛也同样不会继续抓取重复,减少蜘蛛的抓取难度,即使是重复的内容,蜘蛛也只会抓取有价值的那个版本。

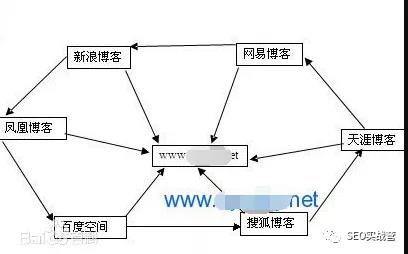

百度的星火计划邀请站长参与原创站点,如果您的网站是本网站首创,非抄袭模仿的、内容和形式都具有独特个性的资源;且具有社会共识价值的资源,符合国家相关规定;不在第二次装载及伪原创之内;您并可提交您的站点到百度原创星火计划站点。这种方法可减少因为站点权重不高,网站内容在被高权重网站转载后,蜘蛛会认为转载的站点是原创的内容,你的站反而是转载采集站点。

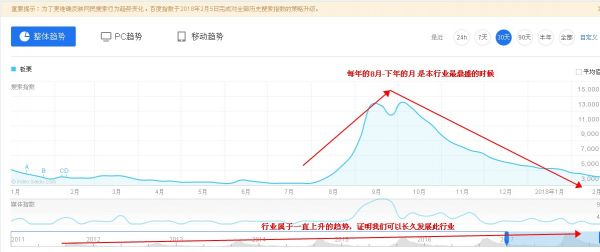

搜索引擎到底如何判断网站内容是否原创,重复内容页面中到底哪个页面才是原创页面,这是任何一个搜索引擎都未曾公布的算法。但娄底人才网()从百度官方的数据了解到,具有“原创”标签的网站,原创星火计划上线前后的同期流量对比显示,原创url流量增长明显。同时,原创星火计划上线后一段时间内原创url流量增长明显并逐渐趋于平稳,可见如果网站能加入百度原创计划,网站在流量提升方面还是有很大帮助的。

申请创业报道,分享创业好点子。点击此处,共同探讨创业新机遇!