WAVE SUMMIT 2022深度学习开发者峰会上周圆满落幕,来自产学研界的专家学者和资深AI工程师在七大平行论坛带来了精彩的技术分享。 本次峰会专设【智能硬核 生态共创】平行论坛,昆仑芯科技生物计算研发总监郑焕鑫受邀参会,并进行“昆仑芯×飞桨:共创智能计算‘芯’生态”的主题演讲 。

昆仑芯适配百度飞桨等主流框架,支持推理和训练场景,生态建设正在逐渐完备,已在丰富的业务场景落地。作为国内人工智能芯片领域的先行者,昆仑芯科技依托团队多年耕耘芯片和智能计算领域的行业影响力,致力于携手上下游合作伙伴,打造智能计算“芯”生态。

以下内容来自演讲实录:

大家好,我是来自昆仑芯科技的郑焕鑫。

昆仑芯科技是一家AI芯片公司,2021年4月完成了独立融资,首轮估值约130亿元。公司前身是百度智能芯片及架构部,在实际业务场景中深耕AI加速领域已十余年,是一家在体系结构、芯片实现、软件系统和场景应用均有深厚积累的AI芯片企业。

昆仑芯科技研发实力雄厚,团队成员拥有全球顶尖学术背景,并提出了100%自研的通用AI计算处理器核心架构昆仑芯XPU,研究成果也在Hot Chips、ISSCC等国际顶级学术会议中成功发表。

在落地实现上,昆仑芯1代在百度搜索引擎、小度等业务中部署超过2万片,是国内唯一一款经历过互联网大规模核心算法考验的云端AI芯片产品。昆仑芯2代采用7nm制程,也已于2021年8月量产。更先进的昆仑芯3代、自动驾驶芯片等多个产品均已启动研发。

随着AI越来越普及,其依托的算力需求也越来越大。在这个时代背景下,昆仑芯的愿景是“成为划时代,全球领先的智能计算公司”,为AI发展提供算力赋能。

昆仑芯在AI芯片上经历了超过10年的发展历程。我们在2011年启动FPGA AI加速器项目,到2015年部署5000片,2017年部署超过12000片,是业界最大的量;2017年发布自研架构昆仑芯XPU;2018年启动昆仑芯;2020年昆仑芯1代大规模部署;2021年昆仑芯2代量产。

昆仑芯软硬件架构及两代产品

不同于GPU的发展历程,昆仑芯1代在AI发展相对成熟的时候量产,在设计阶段就更好地理解了AI场景,提供了更多的加速计算单元,并且保留了足够的通用计算单元,最终达到了更好的性价比。

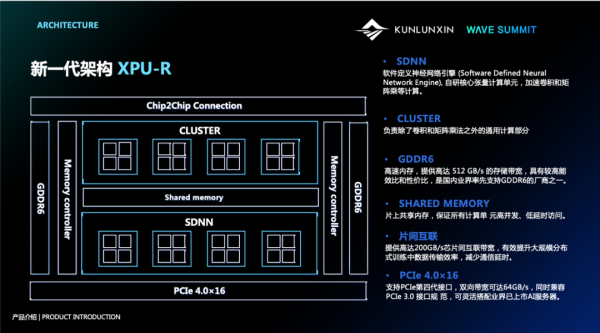

这是我们的昆仑芯XPU架构:SDNN-软件定义神经网络引擎,是我们自研的核心张量计算单元,用于加速卷积和矩阵乘法;Cluster为我们的通用计算部件;我们也是国内业界率先支持GDDR6的厂商之一;我们的Shared Memory片上共享内存,有力保证了计算单元的高并发、低时延访问;提供高达200GB/s的片间互联带宽,有效提升了大规模分布式训练中的数据传输效率,减少通讯延时;支持PCIe第四代接口,双向带宽可达到64GB/s。

这是我们的软件架构图:在应用层,我们支持训练、推理以及科学计算;在框架层,除了深度合作的PaddlePaddle,还支持TensorFlow,PyTorch等;我们提供了丰富的SDK,包括编辑器、图引擎、高性能算子库、高性能通讯库,以及驱动;在环境部署上,我们支持公有云服务、智算中心、智能边缘设备等。

这是我们的产品研发路线,昆仑芯1代采用14nm工艺,昆仑芯2代采用7nm工艺,此外我们的昆仑芯3代、昆仑芯4代都在研发路径中。

昆仑芯1代产品包括两种形式,其中K100是K200的算力一半版本,主要用在边缘端。昆仑芯2代产品中,R200 AI加速卡主要用于推理,支持INT8/INT16/INT32/FP16/FP32等精度,非常值得一提的是昆仑芯R200 AI加速卡支持视频编解码能力;R480-X8 AI加速器组是我们的单机8卡训练方案,提供200GB/s的片间互联带宽。

概括起来,昆仑芯2代有如下特点:

1.通用计算能力显著增强,可灵活支持AI算法的演进,提升资源投入效用;

2.硬件虚拟化,提升AI算力资源的利用率;

3.高性能分布式AI系统,加速AI数据并行和模型并行中的高速数据交换。

介绍完硬件参数,我们看看昆仑芯的软件参数。以R200 AI加速卡为例,相比较于业界主流产品,典型AI负载性能提升1.5倍左右,其中GEMM矩阵乘法性能为1.7倍,BERT典型自然语言处理性能加速比为1.4倍。对Transformer类有同样的效果;Yolov3,Yolov5性能加速1.3倍;ResNet50视觉分类算法加速1.2倍。

昆仑芯AI算力赋能千行百业

昆仑芯科技前身为百度智能芯片及架构部,天然对互联网AI应用有深入了解。以百度搜索场景为例,我们实现了过万片的部署,与飞桨联合优化模型:DeepFM、Wide&Deep。此外,我们在包括百度在内的多家互联网公司上均有不错的落地表现

在智能城市领域,万级别摄像机收集视频流,通过芯片编解码获取图片,对图片进行人脸检索以及比对。该场景主要是以CV类算法为主,我们和飞桨联合优化模型包括:ResNet50、MobileNet-v3、Unet、Yolov3-DarkNet53、SSD-ResNet34 。

工业质检场景,高清工业相机拍摄零件照片进行质量检测。搭载国产AI算力机的质检设备替代人工质检,大大节省了人力,14个月即可收回成本。同时,“5G+AI+工业互联网”解决方案大大提高了整厂的智能化水平,帮助企业降低损耗,提升约10%的良品率。在这个方向上,我们和飞桨联合开发了Yolov3-DarkNet53、SSD-ResNet34。

在目前国内前沿的生物计算领域,我们也对基因测序算法Blast以及蛋白质折叠预测算法进行了硬件适配,并取得了不错的加速比。

综上,我们在互联网、智慧城市、智慧工业、生物计算、智慧金融、智慧政务、智算中心以及智慧交通等各行业 AI 应用落地场景中均提供了多种解决方案。

总结来看,昆仑芯科技最独特优势在于:在百度搜索引擎、小度等业务中部署超过2万片,是国内唯一一款经历了互联网大规模核心算法考验的云端AI芯片,产品的可用性、可靠性、稳定性、鲁棒性得到了验证,也证明了团队在芯片架构、软件栈、工程化系统层级的技术实力。此外,昆仑芯灵活支持多个AI场景,如视觉、语音、NLP和推荐等;不仅如此,昆仑芯也支持HPC、生物计算等算法的加速。

申请创业报道,分享创业好点子。点击此处,共同探讨创业新机遇!

虽然我国汽车芯片行业还处在发展初期,但已经迸发出无限潜力。一方面,智能汽车的发展不断带动需求增长;另一方面,政策引导下,汽车芯片企业持续抢占高地。对此,在7月5日-7日举办的2023年中国汽车论坛上,中国汽车工业协会副秘书长李邵华就做出表示,“中国将成为未来汽车芯片发展的集聚地”。车规芯片行业近日的

2023世界人工智能大会将于7月6日至8日在上海举办。云天励飞将在大会上展示自主设计开发的新一代边缘计算芯片DeepEdge10系列SoC芯片,并公布“天书”大模型的最新动态。欢迎莅临上海世博展览馆H1-C801展台参观交流!同时,云天励飞也将与中国电子、中国信通院、华为等合作伙伴,在WAIC的舞台

近日,酷学院智能产品发布会在深圳闪亮登场。近200位现场观众和近万人次在线观看,共同见证了这一激动人心的时刻。发布会上,酷学院引领大家探索企业培训学习和人才发展领域的新高度,并揭幕其全新的产品智能升级和突破。酷学院产品负责人徐晨通过形象生动、逻辑严谨的讲述,揭晓了全新的智能企业培训和人才发展平台,以

随着人工智能技术的快速发展,各行各业都受到了深刻影响,特别是中小学人工智能教育的普及,已经成为当今不可忽视的重要课程。ChatGPT等人工智能技术的出现,让我们看到了人工智能将成为未来推动科技跨越发展、生产力整体跃升的重要驱动力量之一。在这个背景下,中小学教育已经将人工智能作为重要学习内容,并将科技

文|智能相对论作者|叶远风产业升级如火如荼,通过数字化、智能化来激发“新动能”,已经成为普遍共识。但是,作为一个泛概念,“新动能”到底是什么,又如何具体到一些举措、动作上,才能确保落地,从而切实推动产业升级?业界需要一个关于“新动能”如何被激发的切实路线图。事实上,针对产业升级的“新动能”,最终还是

自字节跳动发布豆包大模型,互联网大厂纷纷就位,击穿“地板价”的打法从C端向B端拓展。这也成为今年“618”最亮眼的价格战。5月15日,字节跳动率先宣布豆包大模型已通过火山引擎开放给企业客户,大模型定价降至0.0008元/千Tokens;5月21日,阿里云宣布0.0005元可得1000tokens,百

2023年可以说是人工智能行业最振奋的一年,大模型的能力每隔一段时间就会上一个新台阶,汹涌澎湃的技术革命迅速影响着每一个人的生活,AGI不再是一种技术理想,而是触手可及的现实。到了2024年,人工智能的热度不减,但口口相传的“百模大战”并未上演。资本市场罕见地“降温”,不少大模型悄无声息地消失,有机

ChatGPT运行日耗70万美金!GPT-4训练成本破10亿美金大关!OpenAI2024年财务警钟敲响,破产风险浮现!国产大模型烧钱大战升级!百度、科大讯飞、阿里、腾讯等巨头已烧掉上百亿资金!大模型背后的“烧钱”豪赌,谁能笑到最后?降低成本大模型成本怎么降低?有两条比较实用的路径大模型背后的成本确

前言:这是白杨SEO公号原创第530篇。为什么写这个?一个星期多前在白杨流量汇群看到有人问,自己实战测试研究了下分享给大家,也许对大家有点用。本文大纲:1、百度智能体是什么?2、百度智能体有什么用?3、百度智能体怎么创建?4、百度智能体如何用(营销)?百度智能体是什么?百度智能体,准确的叫法应该是百

C114讯5月21日消息(九九)阿里云今天抛出重磅炸弹:通义千问GPT-4级主力模型Qwen-Long,API输入价格从0.02元/千tokens降至0.0005元/千tokens,直降97%。这意味着,1块钱可以买200万tokens,相当于5本《新华字典》的文字量。这款模型最高支持1千万toke

近日,OpenAI宣布推出其最新旗舰生成式AI模型GPT-4o。相较于GPT-4Trubo,GPT-4o速度更快、价格也更便宜据悉,ChatGPT可以读取人类的情绪,但读取过程有一点困难。OpenAI,是一家位于美国旧金山的人工智能研究公司,现由营利性公司OpenAILP及非营利性母公司OpenAI

随着人工智能技术的飞速发展,大语言模型(LargeLanguageModels,LLMs)在各行各业的应用日益广泛,尤其是在软件开发、数据分析、客户服务等领域。蘑菇云创客空间[445期开放夜]就以“ChatGPT、Gemini、通义千问等一众大语言模型,哪家更适合您”这样的主题,开展了一次深度的大语